|

|

||||||||

|

mail@gyoergy-pongracz.de |

||||||||

|

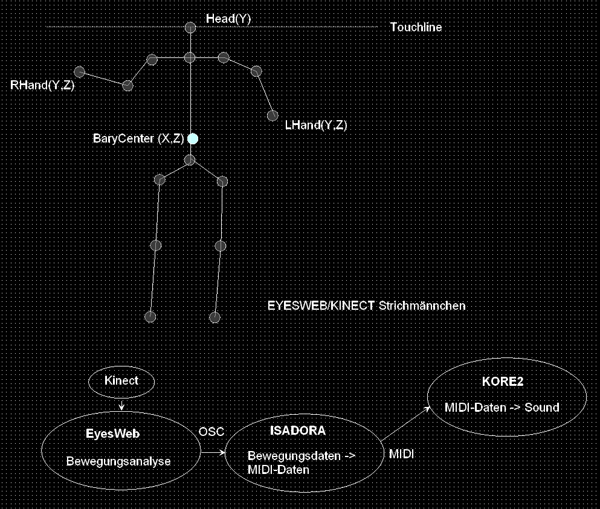

In meiner Arbeit verknüpfe ich in Echt-Zeit körperliche Aktionen und Interaktionen mit Klang- und Bild-“Kompositionen“ im virtuellen kybernetischen Raum. Die Komposition virtueller Environments basiert auf der Verwendung des Camera-Motion-Tracking- Systems "EyesWeb". "EyesWeb" ist in der Lage, audiovisuelle Daten aufzunehmen, zu verarbeiten, zu interpretieren und in einer neuen Form wieder auszugeben. Ziel war es dabei, in den Darstellungen emotionale Stimmungen wie Freude, Wut, und Angst zu identifizieren, um Körpersprache mit dem Computer deuten zu können. "EyesWeb" verbindet ber verschiedenste Parameter physische Aktionsräume mit computergenerierten Multimediaräumen. - Bewegungserfassung/Analyse/Transformation mit Kinect/Eyesweb Ästhetische Frage: was passiert, wenn unsere Körperbewegung in einen numerischen Code übersetzt, analysiert, weiterverarbeitet und für Steuerung für andere technische Prozesse eingesetzt ist? |

|

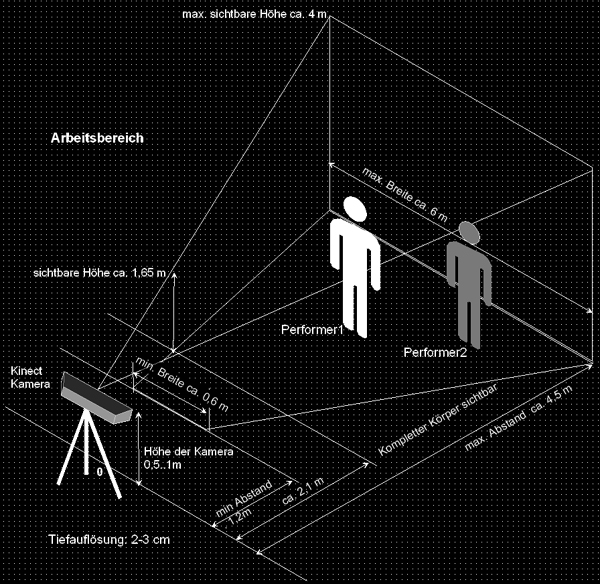

Aufbau der digitalen Bühne mit Kinect-Kamera |

|||

|

|||

|

Funktionsweise der digitalen Bühne: Die Kinect-Kamera besteht aus einem RGB-Sensor mit VGA Auflösung, einem 16-Bit- Tiefensensor und einem Array aus vier Mikrofonen. |

|

Eine mögliche Anwendung |

|

|

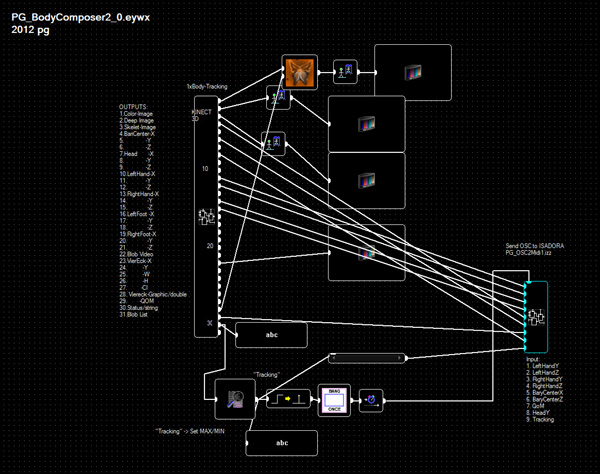

EYESWEB Programmbeispiel

|

|

| [DigitalStage] [VIDEOS] [Technik] [Projects] [Links] [Kontakt] |